北大AI奧數評測,o1-mini比o1-preview分數還高

Omni-MATH團隊 投稿

量子位 | 公衆号 QbitAI

OpenAI的o1系列一發布,傳統數學評測基準都顯得不夠用了。

MATH-500,滿血版o1模型直接拿下94.8分。

更難的奧數邀請賽AIME 2024,o1也獲得83.3%的準确率。

随着現有的數學評測集逐漸被攻克,大家不禁開始好奇:大模型能否勝任更具挑戰性的數學競賽,甚至是奧林匹克數學競賽?

為此,北京大學與阿裡巴巴的研究團隊聯合打造了一個專門用于數學競賽的奧林匹克評測基準——Omni-MATH。

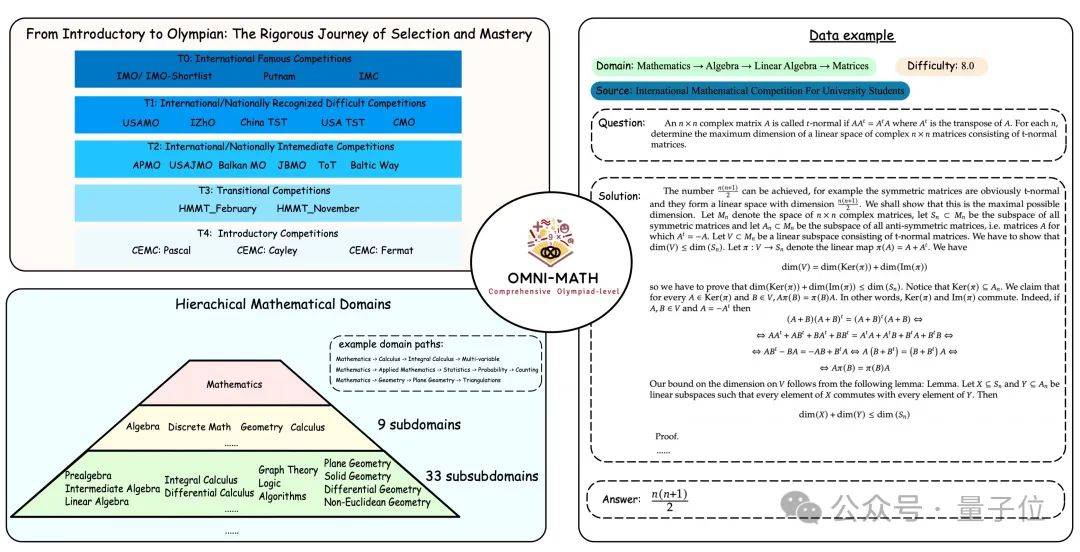

Omni-MATH專門用于評估大型語言模型在奧林匹克水平的數學推理能力。評測集共收錄了 4428 道競賽級别的問題。這些問題經過精心分類,涵蓋了 33 個(及更多)子領域,并且分為 10 個不同的難度級别,使得我們能夠對模型在各種數學學科和複雜程度上的表現進行細緻分析。

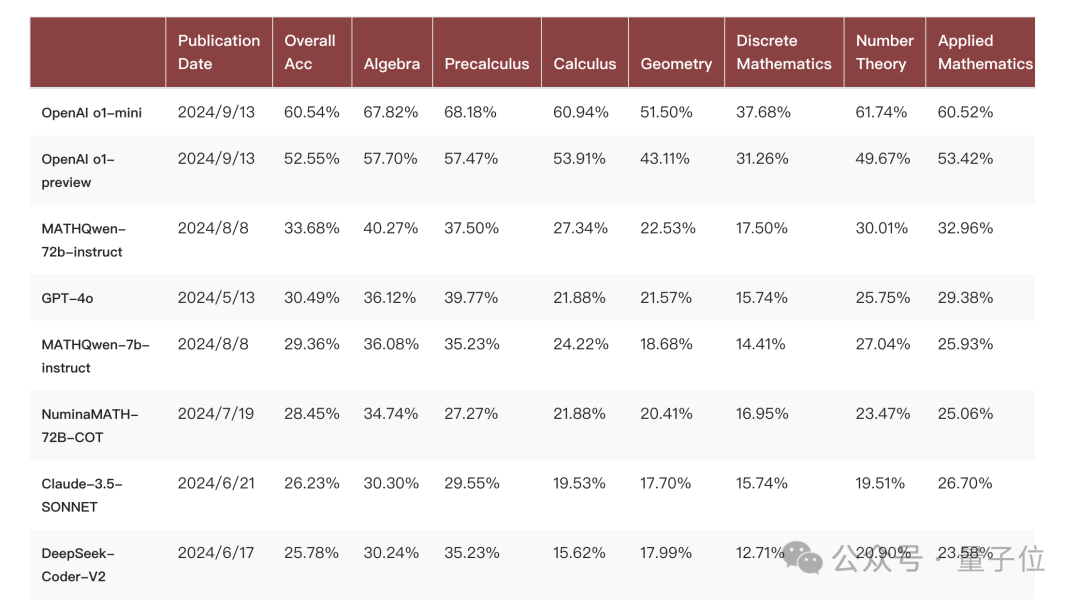

最新排行榜,競争非常激烈:

除去o1滿血版暫時還沒有放出API,作為小模型的o1-mini的表現最好,平均分比o1-preview還要高8%左右。

開源模型最好的是Qwen2-MATH-72b,甚至超過了GPT-4o的表現。

總的來說,o1-mini這種隻關注少部分能力、放棄存儲廣泛世界知識路線的優勢,再次得到驗證。

Omni-MATH:難度大、領域廣

Omni-MATH作為一個數學奧林匹克評測基準,它的特點有三個維度:

人工驗證答案的可靠性:4428道評測問題來自不同的數學競賽和論壇數據,人工參與驗證答案準确性;并且考慮到奧賽難度問題答案的多樣性提供了基于GPT4o和評測模型的評價方式,方便一鍵啟動評測。

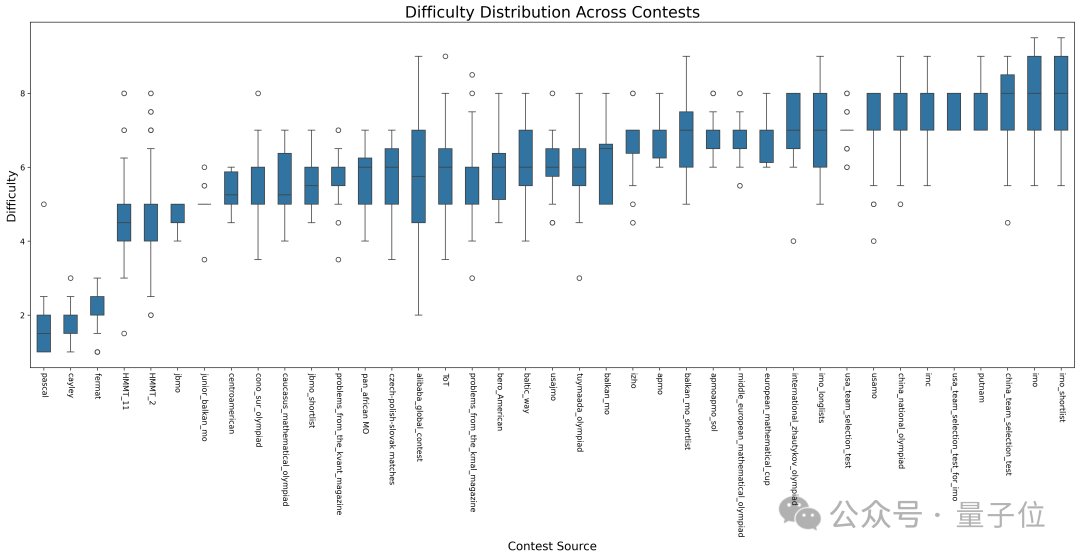

清晰合理的難度分類:評測集整體比較有挑戰性,并且難度跨越非常大。從奧林匹克預備級别(T4)競賽CEMC到最頂級的奧林匹克數學競賽(T0)如IMO、IMC、普特南等等。這些比賽不僅需要選手具備紮實的數學基礎,還需要超高的邏輯推理能力和創造力。數據顯示,隻有極少數智商接近頂尖的人才能在這些比賽中取得優異成績。

題目類型非常廣:共有多于33個子領域的數學問題。根據數學領域的特性,團隊打造了樹狀的領域分類,每個題目涉及一到多個領域,也就是多條樹的路徑,使得我們能夠對模型在各種數學學科和困難程度上的表現進行細緻的分析。”

評測集Omni-MATH的構造 數據構造

研究團隊首先對國内國外基本的奧林匹克數學競賽進行了細緻的調研。從中了解到,一個學生從競賽預備到頂級競賽,中間要經過層層選拔的。

比如對于英國體系,要經過JMC → IMC → SMC → BMO 1 → BMO 2 → IMO整個一層鍊路的選拔(這個IMC(Intermediate Mathematical Challenge)和上述IMC(international mathematical competition for university students)并不是一個比賽);

然而在美國體系中,要經過AMC 8 → AMC 10 → AMC 12 → AIME→ USA(J)MO → IMO整個一層體系的選拔。

這啟發了團隊能否給模型評測同樣也設置一個這種難度層級的體現。因此研究團隊調研了世界範圍内不同難度層級的比賽,使得Omni-MATH在奧林匹克級别的數學測試中,難度上仍然多元化。

另外在奧林匹克級别的數學測試中,實際上涉及的數學領域是非常多的。研究團隊考慮到在模型訓練時,不同領域之間的數據是否有會有化學反應,比如領域A的數據能否讓模型泛化到領域B的提升,這種方向的數據工程是非常有意義的。

為了給這個方向的研究打下基礎,研究人員參考了相關競賽教輔書,在這個評測集中給數據的領域進行了非常細緻的劃分,從數學大類上比如數論、代數、幾何等等開始,一直到領域下面具體的小領域或者知識點。

評測集數據的來源主要有兩個,一個是各種比賽的題目和題解,另外一個是著名數學網站Art of Problem Solving。對于想要的比賽,優先從題解中尋找答案。

如果想要的比賽并未公開題解,團隊從AoPS網站的論壇上爬取回複。考慮到回複都是真實用戶書寫,有一定概率是有問題的,需要進行嚴格的篩選。

研究團隊選取了AoPS網站上候選的并且答案規整的數目大于3的題目,并且選取了3個答案全部一緻的題目作為最終标準。團隊在篩選問題時采用人工篩選,進一步保證了準确性。

數據處理

數據本身的處理:

在爬取到PDF格式的題解後,開發者們使用了Mathpix将其轉換成Latex格式作為題解。在爬取到論壇答案之後,首先用GPT-4o重新format成規整的回複,之後手動檢查是否和原本問題的答案一緻。

對于這兩類來源的數據,團隊人員最後都是用了人工檢查是否和數據源的信息是一緻的。

難度分類:

參考了AoPS網站中關于題目難度分類的情況。

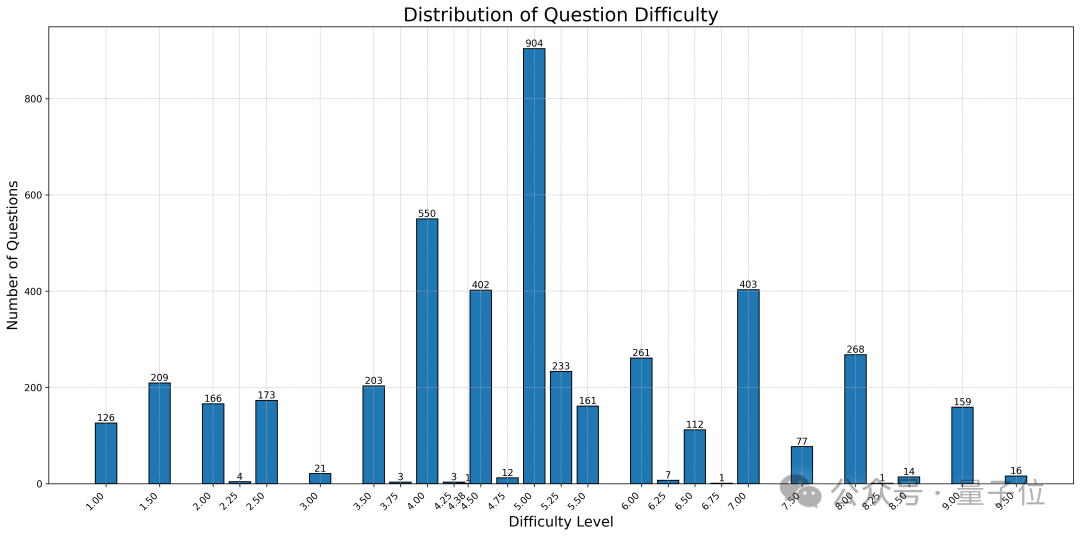

具體而言,不同級别的比賽題目難度有着本質的不同,比如CEMC和IMO之間的題目相差非常大,然而,每個比賽的不同題目也有着不同,比如一次IMO比賽中既有簡單題也有難題。因此評測集的難度分類嚴格按照AoPS網站上給出的不同比賽的每一道題的難度系數(從1到10之間,大多是整數,少數有.5、.25這種難度)。

對于網站上未覆蓋的内容,團隊人員将網頁上的内容整理成了few-shot prompt,并使用了GPT4o給題目難度進行了标注。整體難度的分布和不同比賽題目的分布如下:

領域分類:

和傳統的數學測試基準的分類不同,在奧數這個難度上的題目涉及的領域更多,知識面更廣。

為了更好地組織統一起奧數這些題目以及後續的對于數學領域之間數據的關系的探究,團隊構建了一個更為全面的樹狀分類體系。研究團隊參考了相關競賽教輔書,将奧數相關的領域分為了幾何、代數、數論、應用數學等等領域,之後從這些領域出發,繼續細分成各個領域的小領域,細微的知識點。

這種樹狀分類體系更有助于幫助理解不同題目之間的關系,以及模型在不同領域上的表現。團隊将這一樹狀分類體系作為模闆,并結合競賽輔導書中的實例,構建了few-shot的提示(具體的樹狀結構和提示内容可參考文章末尾的代碼倉庫)。

随後,團隊利用GPT-4o給每道題目分類到一到多個類别當中。

開源的答案驗證器

Omni-Judge是微調Llama3-Instruct得到的驗證器,用于驗證待測的答案和給定的答案是否一緻。由于數學奧賽級别的題目回答的種類非常豐富,用規則評測實際上非常困難。在獲得模型的預測之後,需要判斷模型的輸出是否和标準答案是一緻的。在使用GPT-4o評測之外,我們還提供了一種更簡便的評測方法,利用了GPT4o評測模型時産生的COT數據微調Llama3-Instruct得到了一個開源的驗證器,評測一緻率和GPT-4o高達95%。

參考鍊接:

Project Page:/

Github:/

Dataset:/

Omni-Judge:/

—完—

投稿請發郵件到:

ai@qbitai.com

标題注明【投稿】,告訴我們:

你是誰,從哪來,投稿内容

附上論文/項目主頁鍊接,以及聯系方式哦

我們會(盡量)及時回複你

點這裡👇關注我,記得标星哦~

科技前沿進展日日相見 ~

我來說兩句